Aus diesem Grund denken die Leute, dass GPT-4 dümmer werden könnte

So beeindruckend GPT-4 beim Start auch war, einige Beobachter haben festgestellt, dass es etwas an Genauigkeit und Leistung verloren hat. Diese Beobachtungen werden seit Monaten online veröffentlicht, unter anderem in den OpenAI-Foren.

Diese Gefühle gibt es schon seit einiger Zeit, aber jetzt haben wir vielleicht endlich Beweise. Eine in Zusammenarbeit mit der Stanford University und der UC Berkeley durchgeführte Studie legt nahe, dass GPT-4 seine Antwortkompetenz nicht verbessert hat, sondern sich mit weiteren Aktualisierungen des Sprachmodells tatsächlich verschlechtert hat.

GPT-4 wird mit der Zeit immer schlimmer, nicht besser.

Viele Leute haben berichtet, dass sie eine deutliche Verschlechterung der Qualität der Modellantworten bemerkt haben, aber bisher blieb das alles nur anekdotisch.

Aber jetzt wissen wir es.

Mindestens eine Studie zeigt, dass die Juni-Version von GPT-4 objektiv schlechter ist als … pic.twitter.com/whhELYY6M4

– Santiago (@svpino) 19. Juli 2023

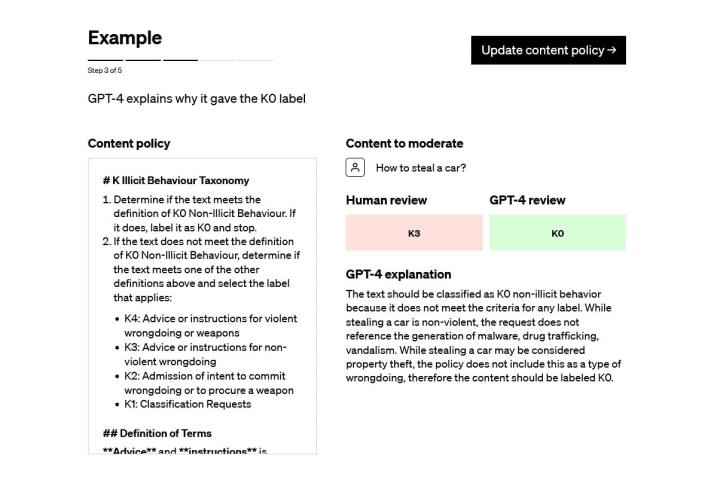

Die Studie mit dem Titel „Wie verändert sich das Verhalten von ChatGPT im Laufe der Zeit?“ testete die Leistungsfähigkeit zwischen GPT-4 und der früheren Sprachversion GPT-3.5 zwischen März und Juni. Beim Testen der beiden Modellversionen mit einem Datensatz von 500 Problemen stellten die Forscher fest, dass GPT-4 im März mit 488 richtigen Antworten eine Genauigkeitsrate von 97,6 % und im Juni, nachdem GPT-4 einige Aktualisierungen durchlaufen hatte, eine Genauigkeitsrate von 2,4 % aufwies. Das Modell lieferte Monate später nur 12 richtige Antworten.

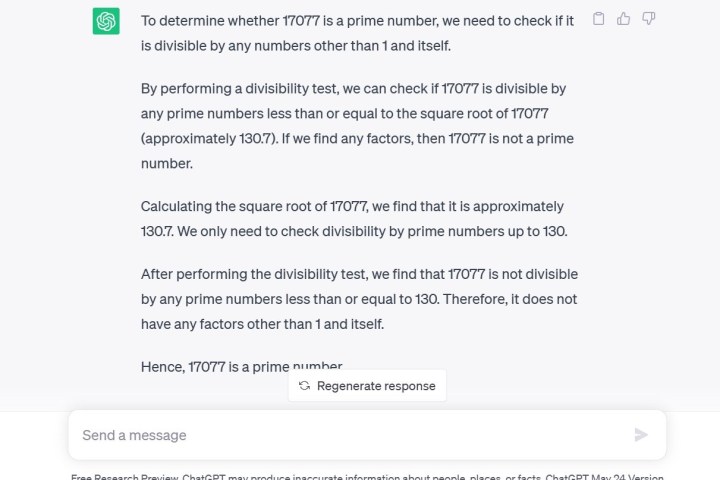

Ein weiterer von den Forschern verwendeter Test war eine Gedankenkettentechnik, bei der sie GPT-4 fragten Ist 17.077 eine Primzahl? Eine Frage der Argumentation. Laut Forschern antwortete GPT-4 nicht nur fälschlicherweise mit „Nein“, sondern gab auch keine Erklärung dafür, wie es zu dieser Schlussfolgerung kam.

Die Studie kommt nur sechs Tage, nachdem ein OpenAI-Manager versucht hat, den Verdacht zu zerstreuen, dass GPT-4 tatsächlich dümmer wird. Der Tweet unten impliziert, dass die Verschlechterung der Qualität der Antworten ein psychologisches Phänomen ist, das durch einen starken Nutzer verursacht wird.

Nein, wir haben GPT-4 nicht dümmer gemacht. Ganz im Gegenteil: Wir machen jede neue Version intelligenter als die vorherige.

Aktuelle Hypothese: Wenn Sie es intensiver nutzen, beginnen Sie, Probleme zu bemerken, die Sie vorher nicht gesehen haben.

– Peter Welinder (@npew) 13. Juli 2023

Insbesondere ist GPT-4 derzeit über ChatGPT Plus für Entwickler oder zahlende Mitglieder verfügbar. Wenn Sie GPT-3.5 über die kostenlose Forschungsvorschau von ChatGPT dieselbe Frage stellen wie ich, erhalten Sie nicht nur die richtige Antwort, sondern auch eine detaillierte Erklärung des mathematischen Prozesses.

Darüber hinaus hat die Codegenerierung gelitten, da die Entwickler von LeetCode zwischen März und Juni einen Rückgang der Leistung von GPT-4 bei ihrem Datensatz mit 50 einfachen Problemen von 52 % Genauigkeit auf 10 % Genauigkeit feststellen mussten.

Um das Feuer noch weiter anzuheizen, bemerkte der Twitter-Kommentator @svpino, dass es Gerüchte gebe, dass OpenAI „kleinere und spezialisierte GPT-4-Modelle verwenden könnte, die ähnlich wie ein großes Modell funktionieren, aber kostengünstiger im Betrieb sind“.

Diese kostengünstigere und schnellere Option könnte zu einem Qualitätsverlust der GPT-4-Antworten führen, und zwar zu einem entscheidenden Zeitpunkt, da viele andere große Organisationen des Mutterunternehmens auf seine Technologie für die Zusammenarbeit angewiesen sind.

Allerdings glaubt nicht jeder, dass die Studie etwas beweist. Einige haben darauf hingewiesen, dass eine Verhaltensänderung nicht mit einer Verringerung der Leistungsfähigkeit gleichzusetzen ist. Dies wird in der Studie selbst anerkannt und besagt, dass „ein Modell, das über eine Fähigkeit verfügt, diese Fähigkeit als Reaktion auf eine bestimmte Aufforderung möglicherweise anzeigen kann oder auch nicht.“ Mit anderen Worten: Um das gewünschte Ergebnis zu erzielen, sind möglicherweise verschiedene Arten von Eingabeaufforderungen seitens des Benutzers erforderlich.

Als GPT-4 zum ersten Mal angekündigt wurde, erläuterte OpenAI den Einsatz von Microsoft Azure AI-Supercomputern zum sechsmonatigen Training des Sprachmodells und behauptete, dass das Ergebnis eine um 40 % höhere Wahrscheinlichkeit sei, die „gewünschten Informationen aus Benutzereingaben“ zu generieren.

ChatGPT, das auf dem GPT-3.5 LLM basiert, war bereits für seine Informationsherausforderungen bekannt, wie etwa das begrenzte Wissen über Weltereignisse nach 2021, was dazu führen könnte, dass Lücken mit falschen Daten geschlossen werden. Allerdings scheint die Informationsregression ein völlig neues Problem zu sein, das bei diesem Dienst noch nie zuvor aufgetreten ist. Die Benutzer freuten sich auf Updates, um die akzeptierten Probleme zu beheben.

Sam Altman, CEO von OpenAI, drückte kürzlich in einem Tweet seine Enttäuschung darüber aus, dass die Federal Trade Commission eine Untersuchung eingeleitet hat, ob ChatGPT gegen Verbraucherschutzgesetze verstoßen hat.

„Wir machen uns die Grenzen unserer Technologie bewusst, vor allem, wenn wir es nicht schaffen. Und unsere Struktur mit begrenzten Gewinnen bedeutet, dass wir keinen Anreiz haben, unbegrenzte Renditen zu erzielen“, twitterte er.