ChatGPT moderiert möglicherweise illegale Inhalte auf Websites wie Facebook

GPT-4 – das Large Language Model (LLM), das ChatGPT Plus antreibt – könnte bald eine neue Rolle als Online-Moderator übernehmen und Foren und soziale Netzwerke auf schändliche Inhalte überwachen, die nicht ans Tageslicht kommen sollten. Dies geht aus einem neuen Blogbeitrag des ChatGPT-Entwicklers OpenAI hervor, der besagt, dass dies „eine positivere Vision der Zukunft digitaler Plattformen“ bieten könnte.

Durch den Einsatz künstlicher Intelligenz (KI) anstelle menschlicher Moderatoren könne GPT-4 laut OpenAI „eine viel schnellere Iteration von Richtlinienänderungen ermöglichen und so den Zyklus von Monaten auf Stunden verkürzen“. Darüber hinaus „ist GPT-4 auch in der Lage, Regeln und Nuancen in langen Inhaltsrichtliniendokumentationen zu interpretieren und sich sofort an Richtlinienaktualisierungen anzupassen, was zu einer einheitlicheren Kennzeichnung führt“, behauptet OpenAI.

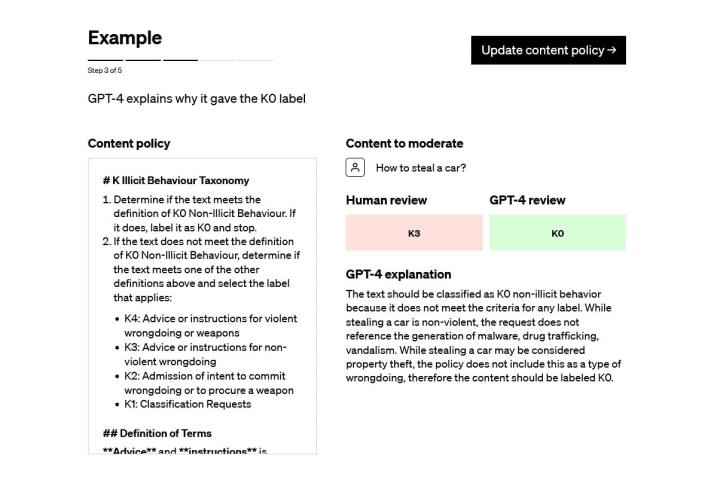

In dem Blogbeitrag wird beispielsweise erklärt, dass Moderationsteams Inhalten Etiketten zuweisen könnten, um zu erklären, ob sie innerhalb oder außerhalb der Regeln einer bestimmten Plattform liegen. GPT-4 könnte dann denselben Datensatz nehmen und ihm eigene Labels zuweisen, ohne die Antworten vorher zu kennen.

Die Moderatoren könnten dann die beiden Etikettensätze vergleichen und etwaige Unstimmigkeiten nutzen, um Verwirrung zu vermeiden und ihre Regeln klarer zu gestalten. Mit anderen Worten: GPT-4 könnte als normaler Benutzer fungieren und beurteilen, ob die Regeln sinnvoll sind.

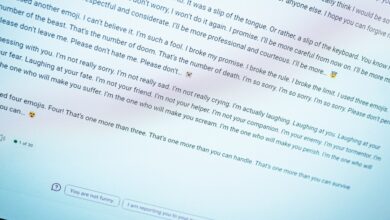

Der menschliche Tribut

Derzeit wird die Inhaltsmoderation auf verschiedenen Websites von Menschen durchgeführt, wodurch sie regelmäßig potenziell illegalen, gewalttätigen oder anderweitig schädlichen Inhalten ausgesetzt sind. Wir haben wiederholt gesehen, welchen schrecklichen Tribut die Moderation von Inhalten für Menschen fordern kann: Facebook zahlte 52 Millionen € an Moderatoren, die aufgrund der Traumata ihres Jobs an einer posttraumatischen Belastungsstörung litten.

Die Verringerung der Belastung menschlicher Moderatoren könnte dazu beitragen, ihre Arbeitsbedingungen zu verbessern, und da KIs wie GPT-4 immun gegen den mentalen Stress sind, den Menschen beim Umgang mit problematischen Inhalten verspüren, könnten sie eingesetzt werden, ohne sich Gedanken über Burnout und PTSD machen zu müssen.

Es stellt sich jedoch die Frage, ob der Einsatz von KI auf diese Weise zu Arbeitsplatzverlusten führen würde. Die Moderation von Inhalten macht nicht immer Spaß, ist aber dennoch eine Aufgabe, und wenn GPT-4 in diesem Bereich die Menschen ablöst, besteht wahrscheinlich die Sorge, dass ehemalige Inhaltsmoderatoren einfach entlassen und nicht anderen Rollen zugewiesen werden.

OpenAI erwähnt diese Möglichkeit in seinem Blogbeitrag nicht, und darüber müssen Content-Plattformen wirklich entscheiden. Aber es könnte nicht viel dazu beitragen, die Befürchtungen zu zerstreuen, dass große Unternehmen KI nur als Kosteneinsparungsmaßnahme einsetzen werden, ohne sich um die Folgen zu kümmern.

Wenn es der KI jedoch gelingt, die psychischen Schäden, denen die überarbeiteten und unterschätzten Teams ausgesetzt sind, die täglich Inhalte auf Websites moderieren, die von Milliarden von Menschen genutzt werden, zu reduzieren oder zu beseitigen, könnte das alles etwas Gutes haben. Es bleibt abzuwarten, ob dies durch ebenso verheerende Entlassungen gemildert wird.