Forscher haben gerade das größte Rätsel der KI gelöst

Die großen Sprachmodelle, die heutigen Chatbots wie ChatGPT, Gemini und Claude zugrunde liegen, sind immens leistungsfähige generative KI-Systeme und zudem immens stromhungrige Systeme.

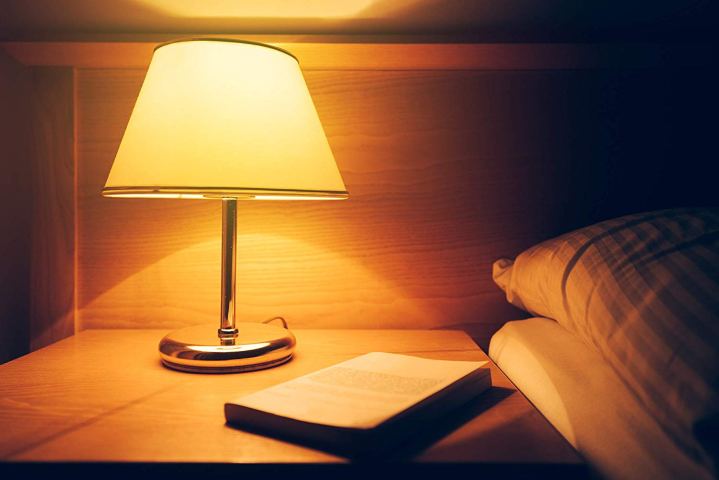

Das ist offenbar auch gar nicht nötig, denn aktuelle Forschungsergebnisse der University of California in Santa Cruz haben gezeigt, dass moderne LLMs, die Milliarden von Parametern verarbeiten, mit nur 13 Watt Leistung auskommen, ohne dass die Leistung nachlässt. Das entspricht ungefähr dem Verbrauch einer 100-W-Glühbirne und ist 50-mal besser als die 700 W, die eine Nvidia H100 GPU verbraucht.

„Wir haben die gleiche Leistung zu wesentlich geringeren Kosten erreicht – wir mussten lediglich die Funktionsweise neuronaler Netzwerke grundlegend ändern“, sagte Jason Eshraghian, der Hauptautor der Studie. „Dann sind wir noch einen Schritt weitergegangen und haben maßgeschneiderte Hardware gebaut.“ Dies gelang ihnen, indem sie die Multiplikationsmatrix des neuronalen Netzwerks abschafften.

Die Matrixmultiplikation ist ein Eckpfeiler der Algorithmen, die den heutigen LLMs zugrunde liegen. Wörter werden als Zahlen dargestellt und dann in Matrizen organisiert, wo sie gewichtet und miteinander multipliziert werden, um Sprachausgaben zu erzeugen, die von der Wichtigkeit bestimmter Wörter und ihrer Beziehung zu anderen Wörtern im Satz oder Absatz abhängen.

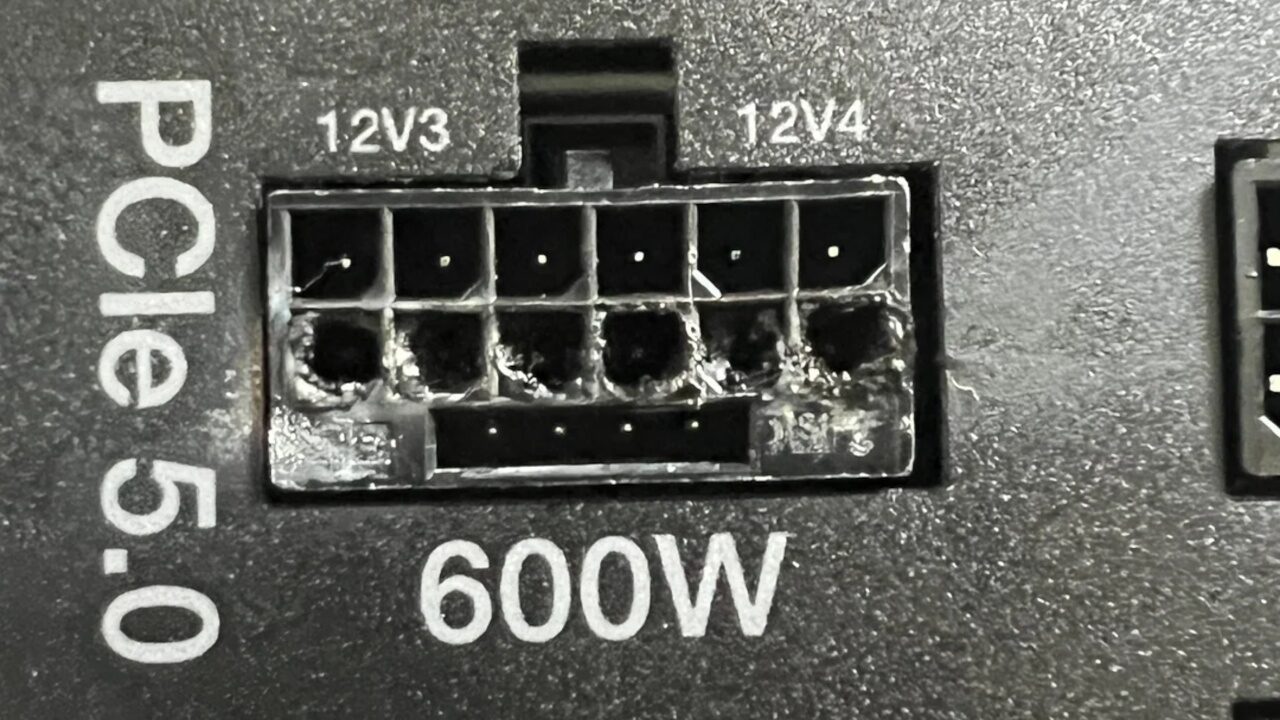

Diese Matrizen werden auf Hunderten physisch getrennter GPUs gespeichert und bei jeder neuen Abfrage oder Operation abgerufen. Der Prozess des Datentransports, der zwischen den zahlreichen Matrizen multipliziert werden muss, kostet eine beträchtliche Menge an Strom und damit Geld.

Um dieses Problem zu umgehen, zwang das Team der UC Santa Cruz die Zahlen in den Matrizen in einen ternären Zustand – jede einzelne Zahl hatte entweder den Wert minus eins, null oder positiv eins. Dadurch können die Prozessoren die Zahlen einfach summieren, anstatt sie zu multiplizieren. Diese Änderung macht für den Algorithmus keinen Unterschied, spart aber enorme Kosten in Bezug auf die Hardware. Um die Leistung trotz der Reduzierung der Anzahl der Operationen aufrechtzuerhalten, führte das Team zeitbasierte Berechnungen in das System ein und schuf damit effektiv ein „Gedächtnis“ für das Netzwerk, wodurch die Geschwindigkeit erhöht wurde, mit der es die verringerten Operationen verarbeiten konnte.

„Aus Sicht eines Schaltkreisdesigners ist der Mehraufwand einer Multiplikation, der mit enormen Kosten verbunden ist, nicht erforderlich“, so Eshraghian. Und obwohl das Team sein neues Netzwerk auf benutzerdefinierter FGPA-Hardware implementiert hat, ist es zuversichtlich, dass viele der Effizienzverbesserungen mithilfe von Open-Source-Software und geringfügigen Hardwareanpassungen auch in bestehende Modelle integriert werden können. Sogar auf Standard-GPUs konnte das Team eine zehnfache Reduzierung des Speicherverbrauchs feststellen und gleichzeitig die Betriebsgeschwindigkeit um 25 % steigern.

Da Chiphersteller wie Nvidia und AMD die Grenzen der GPU-Prozessorleistung immer weiter verschieben, ist der Strombedarf (und die damit verbundenen Kosten) der Rechenzentren, in denen diese Systeme untergebracht sind, in den letzten Jahren stark gestiegen. Mit der Zunahme der Rechenleistung steigt auch die Menge an Abwärme, die die Chips erzeugen – Abwärme, die nun ressourcenintensive Flüssigkeitskühlsysteme benötigt, um sie vollständig abzuleiten.

Arm-CEO Rene Haas warnte The Register im April, dass KI-Rechenzentren bis zum Ende des Jahrzehnts 20–25 % der gesamten US-Stromproduktion verbrauchen könnten, wenn nicht schnell Gegenmaßnahmen ergriffen würden.